H100 GPU, 아키텍처 '호퍼(Hopper)' 적용한 제품

"H100 20개가 전 세계 인터넷 트래픽 규모 맞먹어"

디지털 트윈, 딥러닝 추론, AI 언어 모델 발전 도움

해당 제품 이르면 올해 중순 전 세계에서 이용 가능

엔비디아(NVIDIA)가 'H100 GPU'를 공개했다. 새로운 GPU 아키텍처 '호퍼(Hopper)'를 쓴 제품이다. 디지털 트윈, 딥러닝 추론, 인공지능(AI) 언어, 딥러닝 추론 등 전방위적 산업에 사용 가능하다. 엔비디아는 이 칩을 빠르면 오래 중순 전 세계에 공급하겠다고 밝혔다.

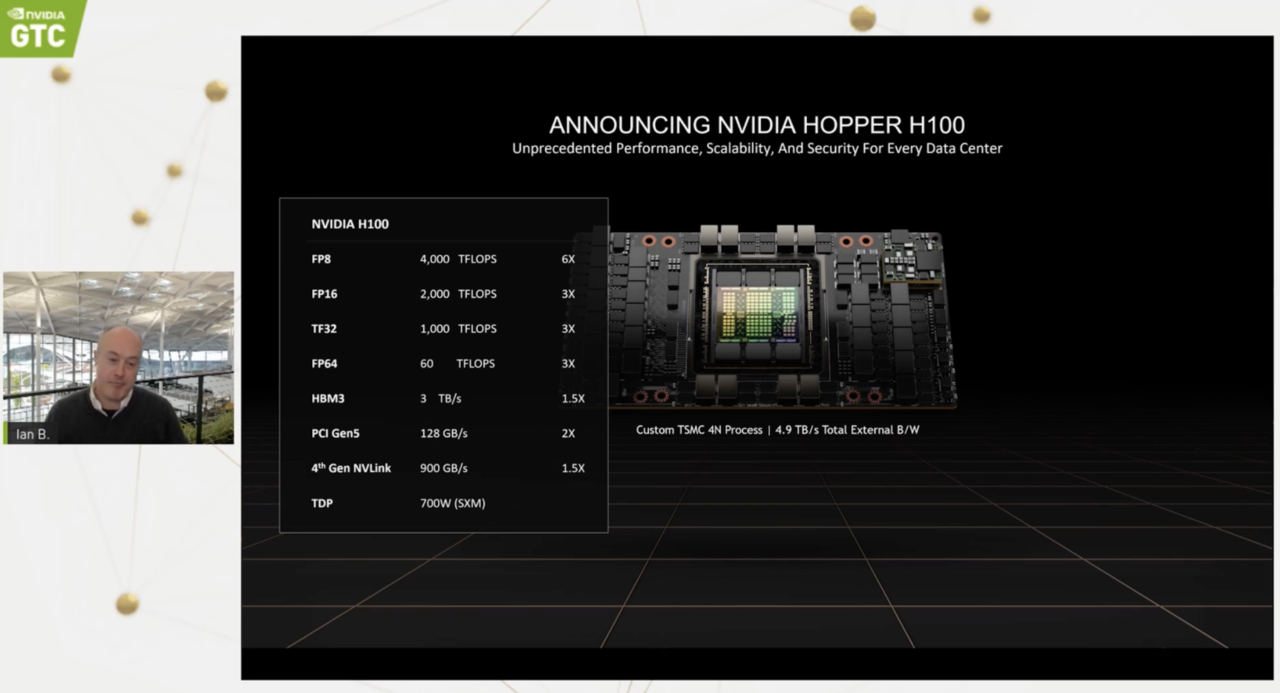

이안 벅(Ian Buck) 엔비디아 수퍼컴퓨팅 책임자는 22일(미국 현지시간) 열린 'GTC 2022'에서 H100에 대해 기존 제품보다 AI 연산에 더 최적화된 기능을 제공한다고 설명했다. 그는 "H100은 차세대 TSMC 4N 프로세스를 사용해 트랜지스터 800억 개를 탑재했다"며 "AI, 고성능컴퓨팅(HPC), 메모리 대역폭, 인터커넥트, 통신을 고속화하는 기능을 갖췄다"고 설명했다.

젠슨 황 엔비디아 최고경영자(CEO)는 이번 GTC 기조연설에서 “데이터센터는 AI 공장”이라며 H100 를 ‘세계 AI 엔진’이라고 강조하기도 했다.

H100은 초당 약 5테라바이트(TB)로 외부 접속이 가능하다. 이안 벅의 발표에 따르면 해당 칩은 HBM3를 사용하는 최초의 GPU다. 메모리 대역폭은 초당 3테라바이트(TB)다. H100가 20대 있으면 전 세계 인터넷 트래픽과 동등한 성능을 유지할 수 있을 정도다. 그는 “해당 기술로 사용자는 데이터 추론을 실행하는 고급 추천 시스템이나 대규모 언어 모델을 실시간으로 받을 수 있다”고 설명했다.

그는 “H100이 새로운 트랜스포머 엔진 역할도 할 수 있다”며 “H100 액셀러레이터 트랜스포머 엔진은 기존 세대와 비교했을 때 속도가 6배 더 빠르다”고 말했다. 해당 제품은 기밀 컴퓨팅(confidential computing) 기능을 갖춘 첫 액셀러레이터기도 하다. 그는 “AI 모델과 고객 데이터를 처리 과정에서 보호할 수 있다”고 강조했다. 책임자 설명에 따르면 공유 클라우드 인프라뿐만 아니라 의료, 금융 서비스 등 보안 산업까지 영향을 미치는 기술이 될 전망이다.

이안 벅 책임자는 4세대 ‘엔비디아 엔비링크(NVIDIA NVLink)’도 언급했다. 가장 큰 AI 모델을 고속화하기 위해 만들었다. 새로운 외부 엔비링크 스위치와 조합할 수 있어 서버 이외의 네트워크를 확장할 수 있다. 기존 기술보다 9배 높은 대역폭으로 최대 256대 H100 GPU를 연결할 수 있다.

벅 책임자는 “H100와 엔비디아가 결합해 이룬 기술 혁신은 이제 시작이다”며 “AI 추론이나 훈련 리더십을 확장해 대규모 AI 모델을 통해 실시간 몰입형 애플리케이션을 가능하게 한다”고 말했다. H100은 기업 클라우드, 하이브리드 클라우드, 에지 등 모든 유형의 데이터 센터에 적용할 수 있다. 이르면 올해 중순 전 세계에서 이용 가능하게 될 전망이다.

AI타임스 김미정 기자 kimj7521@aitimes.com

Copyright © '인공지능 전문미디어' AI타임스 (http://www.aitimes.com/)

무단전재 및 재배포 금지

[GTC 2022] 엔비디아가 출시한 새 GPU, 성능은? - AI타임스

엔비디아(NVIDIA)가 \'H100 GPU\'를 공개했다. 새로운 GPU 아키텍처 \'호퍼(Hopper)\'를 쓴 제품이다. 디지털 트윈, 딥러닝 추론, 인공지능(AI) 언어, 딥러닝 추론 등 전방위적 산업에 사용 가능하다. 엔비디

www.aitimes.com

'AI테크' 카테고리의 다른 글

| [GTC 2022] 메디컬 AI, 건강 수명 연장하는 AI 기술 개발 앞장서 (0) | 2022.03.24 |

|---|---|

| [GTC 2022] 젠슨 황 엔비디아 CEO "AI 새 물결, 우리가 주도할 것" (0) | 2022.03.23 |

| 신음하는 지구, 최악의 가뭄…AI 기술로 대응한다 (0) | 2022.03.23 |

| 러시아·우크라전쟁서 'AI와 무기 융합의 위험성' 떠올라 (0) | 2022.03.22 |

| "나처럼 찍어봐"...미학 이해하는 AI 로봇 사진사 등장 (0) | 2022.03.22 |